BERT Pre-training of Deep Bidirectional Transformers for Language Understanding

论文信息

- 发表机构:Google AI Language

- 发表时间:2018-10

- 论文链接:https://arxiv.org/abs/1810.04805

简介

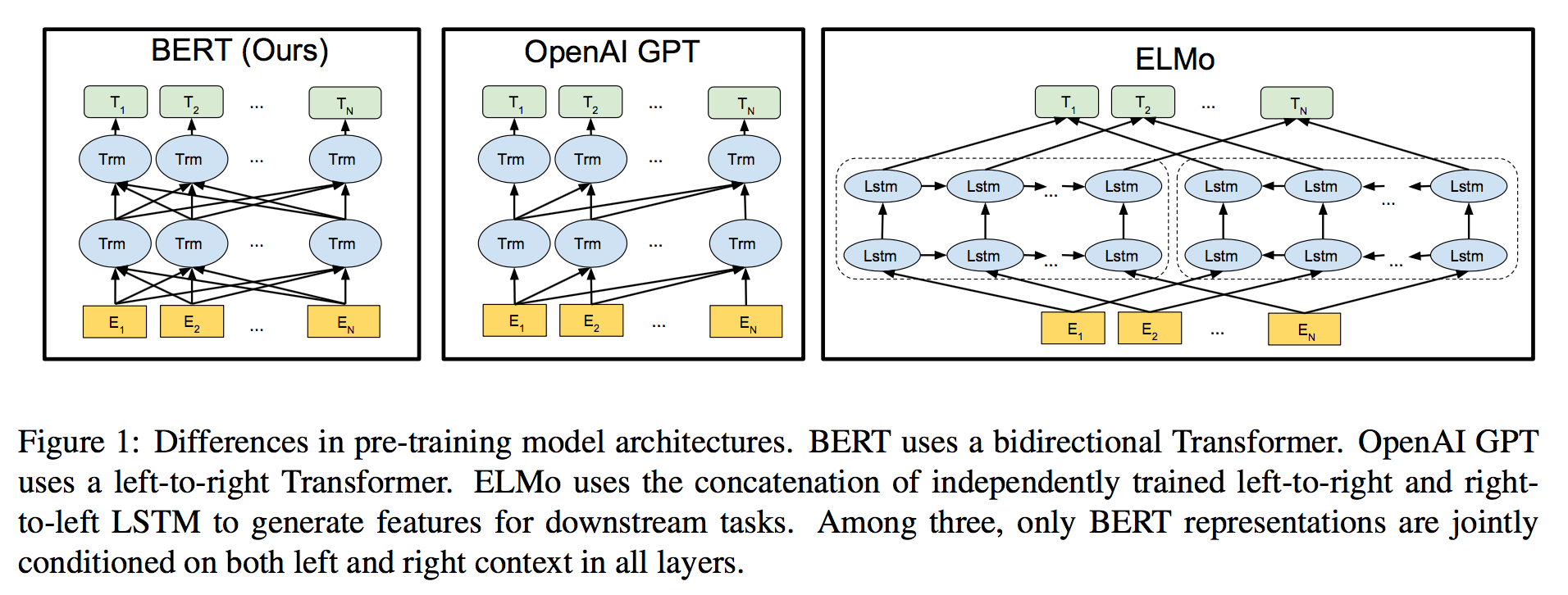

语言模型预训练对于提升很多自然语言处理任务有大帮助,这些任务包括句子级别任务例如自然语言推理、释义)、单词符号级别任务(例如命名实体识别、问答)。有两种策略将预训练的语言表示应用到这些任务上:基于特征的策略和微调优化的策略。这篇文章改进了微调优化的策略提出了BERT方法(Bidirectional Encoder Representations from Transformers)。

BERT

模型结构

BERT Pre-training of Deep Bidirectional Transformers for Language Understanding

http://zhaoshuaijiang.com/2018/12/11/paper-bert/